Introducción a Procore Analytics 2.0

- Última actualización

- Guardar como PDF

Tabla de contenido

- Conector Procore Analytics Nube

- Comenzar la configuración

- Elija un método de conexión de datos

- Conéctese al escritorio de Power BI

- Conexión a SQL Server mediante Python (SSIS)

- Conectarse a SQL Server mediante la biblioteca de Python

- Conexión a SQL Server mediante Python Spark

- Conexión a ADLS mediante Azure Functions

- Conéctese a ADLS mediante Python

- Conexión a ADLS mediante Spark

- Conexión a Fabric Lakehouse mediante Data Factory

- Conéctese a Fabric Lakehouse mediante cuadernos de tela

- Conexión a SQL Server mediante Azure Functions

- Conexión a SQL Server mediante Data Factory

- Conexión a SQL Server mediante Fabric Notebook

- Conectar a Databricks

- Conéctese a Snowflake usando Python

- Conéctese a Amazon S3 mediante Python

- Construye tu propia conexión

Conector Procore Analytics Nube

Introducción

Nube Connector es la forma en que Procore comparte datos, inteligencia y análisis con nuestros clientes. Esto se puede compartir directamente con herramientas de generación de informes como Power BI o Tableau. También se puede compartir con los almacenes de datos, almacenes, lagos u otras aplicaciones de los clientes. Los clientes pueden incluso crear un acceso programático a sus datos utilizando Nube Connector para una verdadera automatización. Nube Connector se basa en el protocolo de uso compartido abierto Delta Share.

Opciones del conector de datos guiados de Procore Analytics 2.0

Delta Sharing es el primer protocolo abierto de la industria para el intercambio seguro de datos, lo que simplifica el intercambio de datos con otras organizaciones, independientemente de las plataformas informáticas que utilicen. Muchas aplicaciones pueden acceder a los datos con Delta Share. Sin embargo, para mejorar aún más la experiencia del cliente, Procore ha agregado conectores, código prediseñado y guías para las siguientes plataformas, lo que reduce el tiempo de configuración y la complejidad para permitir una conexión perfecta y lista para usar.

- Servidor SQL

- SSIS Python

- Biblioteca de Python

- Chispa de Python

- Azure

- ADLS Azure Functions

- ADLS Python

- Chispa de ADLS

- Fábrica de datos de Lakehouse Fabric

- Cuaderno de tela Lakehouse

- SQL Server Azure Functions

- Factoría de datos de SQL Server Fabric

- Cuaderno de SQL Server Fabric

- Databricks

- Copo de nieve

- Amazon S3

- Guías para escribir el tuyo propio (GitHub)

¡Próximamente habrá más conectores de datos!

Acceder a la documentación y al código

La documentación completa y los ejemplos de código están disponibles en el producto Procore Analytics directamente en la aplicación web de Procore a la que pueden acceder sus administradores de Procore. Estos recursos proporcionan instrucciones paso a paso, fragmentos de código y mejores prácticas para ayudarlo a configurar y administrar su integración de datos de manera efectiva.

Siguientes pasos

Continúe con la siguiente sección de esta guía para comenzar el proceso de configuración.

Para consultas o asistencia adicionales, comuníquese con su gerente de cuenta o con nuestro equipo de soporte.

Verificar permisos

Nota:

- Debe tener habilitada la herramienta de análisis a nivel compañía para la cuenta Procore de su compañía.

- Cualquier persona con acceso de nivel "Administrador" a la herramienta Analytics puede otorgar acceso a usuarios adicionales a la herramienta Analytics.

- Los usuarios deben tener acceso de nivel "Administrador" a la herramienta Analytics para generar un token de acceso.

- Cualquier cambio en los permisos de un usuario en el Directorio de Analytics tardará hasta 24 horas en estar activo.

Debe asegurarse de que se asignen los permisos adecuados para generar un token de acceso para que pueda comenzar a conectar sus datos de Procore a su solución de BI. El acceso a Analytics está vinculado a sus credenciales de inicio de sesión de Procore, lo que le permite generar un único token de acceso. El token de acceso es una cadena de dígitos que se introducirá en el sistema de BI para acceder a los datos.

Normalmente, los usuarios que necesitan tokens de acceso son ingenieros de datos o desarrolladores de Power BI. Si tienes acceso a Analytics en varias empresas, tu token te permitirá extraer datos de todas ellas. El token está vinculado a usted, no a una empresa específica, por lo que sigue siendo el mismo en todas las empresas a las que tiene acceso.

A los administradores de compañías y proyectos se les otorgará un rol de administrador de forma predeterminada. Se permiten los siguientes niveles de acceso de usuario para la herramienta Analytics:

- Ninguno: Sin acceso a los datos de Analytics.

- Administrador: tiene permisos de acceso total a los datos de todas las herramientas y proyectos (excepto ciertos datos marcados como privados, como los datos de correspondencia).

Hay dos formas de asignar permisos a usuarios individuales:

Revocación del acceso

El acceso a los datos de la herramienta Analytics se revocará cuando se eliminen los permisos de un usuario para la herramienta. Además, si el registro de contacto de un usuario se vuelve inactivo, también perderá el acceso a los datos de Analytics.

Generar credenciales de acceso a datos

Para empezar a acceder a los datos de Procore, hay dos opciones para generar las credenciales de acceso a los datos: el método de conexión directa de Databricks o el método Delta Share Token. El token de acceso es una cadena de dígitos que ingresará en el conector de datos correspondiente para acceder a los datos.

Consideraciones

- Debe tener habilitada la herramienta Procore Analytics.

- De forma predeterminada, todos los administradores de la compañía tienen acceso de nivel "Administrador" a Analytics en el directorio.

- Cualquier persona con acceso de nivel "Administrador" a Analytics puede conceder acceso a usuarios adicionales a la herramienta Analytics.

- Los usuarios deben tener acceso de nivel "Administrador" a la herramienta Analytics para generar un token de datos.

Pasos

- Inicie sesión en Procore.

- Haga clic en el icono Cuenta y perfil en el área superior derecha de la barra de navegación.

- Haga clic en Configuración de mi perfil.

- En Elija su conexión con Procore Analytics, tiene dos opciones para generar credenciales:

- Databricks se conecta directamente o genera un token de acceso personal con Delta Share.

- Escriba el Identificador de uso compartido de Databricks para el método de conexión directa de Databricks y, a continuación, haga clic en Conectar. Consulte Conectar los datos de Procore a un área de trabajo de Databricks para obtener más información.

- Para el método de token, seleccione Delta Share Token.

- Asegúrese de elegir una fecha de vencimiento.

- Haga clic en Generar tokens.

¡Importante! Se recomienda que copie y almacene su token para referencia futura, ya que Procore no almacena tokens para los usuarios. - Utilizará su token de portador, su nombre de recurso compartido, la URL del servidor de uso compartido de Delta y su versión de credenciales de uso compartido para comenzar a acceder a sus datos e integrarlos.

- Explore las secciones adicionales de la Guía de introducción para conocer los próximos pasos para conectar sus datos en función del método de conexión de datos deseado.

Nota:

- El token desaparecerá después de una hora o también desaparecerá si navega fuera de la página. Para generar un nuevo token, vuelva al paso 1.

- Los datos pueden tardar hasta 24 horas en hacerse visibles.

- No regenere su token durante este tiempo de procesamiento, ya que hacerlo puede causar problemas con su token.

Cargar informes en Power BI (si corresponde)

- Navegue a Procore Analytics desde el menú Herramientas de su compañía.

- Vaya a la sección Introducción .

- En Archivos de Power BI, seleccione y descargue los informes de Power BI disponibles.

- Inicie sesión en el servicio Power BI con sus credenciales de inicio de sesión de Power BI.

- Cree un espacio de trabajo donde desee almacenar los reportes de Procore Analytics de su compañía. Consulte la documentación de soporte técnico de Power BI de Microsoft para obtener más información.

Notas: Es posible que se apliquen requisitos de licencia. - En el área de trabajo, haga clic en Cargar.

- Ahora haga clic en Examinar.

- Seleccione el archivo de reporte desde su ubicación en su computadora y haga clic en Abrir.

- Después de cargar el archivo, haga clic en Filtrar y seleccione Modelo archivado.

- Pase el cursor sobre la fila con el nombre del reporte y haga clic en el icono de puntos suspensivos verticales

.

. - Haga clic en Configuración.

- En la página de configuración, haga clic en credenciales de origen de datos y luego haga clic en Editar credenciales.

- En la ventana "Configurar [Nombre del reporte]" que aparece, complete lo siguiente:

- Método de autenticación: Seleccione "Clave".

- Clave de cuenta: ingrese el token que recibió de la página de generación de token en Procore.

- Configuración de nivel de privacidad para esta fuente de datos: seleccione el nivel de privacidad. Recomendamos seleccionar "Privado" o "Organizativo". Consulte la documentación de soporte de Power BI de Microsoft para obtener más información sobre los niveles de privacidad.

- Haga clic en Iniciar sesión.

- Haga clic en Refresh y haga lo siguiente:

- Zona horaria: seleccione la zona horaria que desea utilizar para las actualizaciones de datos programadas.

- En Configurar un programa de actualización, gire el interruptor a la posición ENCENDIDO.

- Frecuencia de actualización: seleccione "Diario".

- Hora: haga clic en Agregar otra hora y seleccione 7:00 a.m.

Nota: Puede agregar hasta 8 tiempos de actualización. - Opcional:

- Marque la casilla de verificación "Enviar notificaciones de error de actualización al propietario del dataset" para enviar notificaciones de falla de actualización.

- Ingrese las direcciones de correo electrónico de cualquier otro colega al que desee que el sistema envíe notificaciones de falla actualizada.

- Haga clic en Aplicar.

- Para verificar que los ajustes se configuraron correctamente y que los datos del reporte se actualizarán correctamente, regresen a la página "Filtrar y seleccionar Modelo de devolución" y complete los siguientes pasos:

- Coloque el cursor sobre la fila con el nombre del reporte y haga clic en el icono de flecha circular para actualizar los datos manualmente.

- Verifique la columna "Actualizada" para ver si hay un icono de advertencia

.

.

- Si no aparece ningún icono de advertencia, los datos del informe se han actualizado correctamente.

- Si se muestra un icono de advertencia, se ha producido un error. Haga clic en el icono de advertencia

para ver más información sobre el error.

para ver más información sobre el error.

- Para eliminar el tablero en blanco, el servicio Power BI creado automáticamente, complete los siguientes pasos:

- Coloque el cursor sobre la fila con el nombre del tablero. Haga clic en el icono de puntos suspensivos

y haga clic en Eliminar.

y haga clic en Eliminar.

- Coloque el cursor sobre la fila con el nombre del tablero. Haga clic en el icono de puntos suspensivos

- Para verificar que el reporte se renderiza correctamente, navegue hasta la página "Todo" o "Contenido" y haga clic en el nombre del reporte para ver el reporte en el servicio Power BI.

Recomendación

Haga referencia a la columna "Tipo" para asegurarse de que haga clic en el reporte en lugar de un activo diferente.

- Repita los pasos anteriores dentro de Power BI para cada archivo de informe de Procore Analytics.

Conéctese al escritorio de Power BI

Nota:

Estos métodos de conexión suelen ser utilizados por profesionales de datos.Conectar nuevos datos

- Abra su escritorio de Power BI.

- Haga clic en Obtener datos y seleccione Más.

- En la barra de búsqueda, escriba "Compartir en Delta".

- Seleccione Compartir en Delta, luego haga clic en Conectar.

- Escriba o pegue la URL del servidor de uso compartido Delta que recibió de Procore.

- Haga clic en Aceptar.

- Si es la primera vez que se conecta a esta fuente, se le pedirá que proporcione su token de portador de uso compartido de Delta.

- Haga clic en Conectar.

- Después de la autenticación, seleccione las tablas Procore Analytics que desea ingresar en su reporte Power BI.

- Seleccione Cargar para ver su reporte o seleccione Transformar datos para hacer más revisiones en Power Query.

Conectarse a una plantilla existente

- Abra Power BI Desktop.

- Haga clic en el menú desplegable Transformar datos y seleccione Configuración de fuente de datos .

- Seleccione Editar permisos.

- Haga clic en Editar.

- Introduzca el token que ha recibido de Analytics 2.0.

- Haga clic en Actualizar.

- Las columnas de presupuesto personalizadas ahora aparecerán en las tablas Budget y BudgetSnapshots.

Conexión a SQL Server mediante Python (SSIS)

Descripción general

La herramienta Procore Analytics Nube Connect Access es una interfaz de línea de comandos (CLI) que lo ayuda a configurar y administrar las transferencias de datos de Procore a MS SQL Server. Consta de dos componentes principales:

- user_exp.py (Utilidad de configuración de la instalación)

- delta_share_to_azure_panda.py (script de sincronización de datos)

Requisitos previos

- Python y pip instalados en su sistema.

- Acceso a Procore Delta Share.

- Credenciales de la cuenta de MS SQL Server.

- Instale las dependencias necesarias: pip install -r requirements.txt.

Pasos

- Configuración inicial

- Sincronización de datos

- Configuración de recursos compartidos delta

- Configuración de MS SQL Server

- Configuración de SSIS

Configuración inicial

- Ejecute la utilidad de configuración:

Python user_exp.py

Esto te ayudará a configurar lo siguiente:

- Configuración de origen de recursos compartidos delta

- Configuración de destino de MS SQL Server

- Preferencias de programación

Sincronización de datos

Después de la configuración, tiene dos opciones para ejecutar la sincronización de datos:

- Python de ejecución directa

delta_share_to_azure_panda.py

O - Ejecución programada

Si se configura durante la configuración, el trabajo se ejecutará automáticamente de acuerdo con su cron schedule.

Configuración de recursos compartidos delta

- Cree un nuevo archivo denominado config.share con sus credenciales de Delta Share en formato JSON.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"endpoint": "[1]"

}

- Obtener campos obligatorios:

Nota: Estos detalles se pueden obtener de la aplicación web Procore Analytics.- ShareCredentialsVersion: número de versión (actualmente 1).

- BearerToken: Su token de acceso a Delta Share.

- Punto de conexión: la URL del punto de conexión de Delta Share.

- Guarde el archivo en un lugar seguro.

- Al configurar la fuente de datos, se le pedirá que proporcione:

- Lista de tablas (separadas por comas).

- Dejar en blanco para sincronizar todas las tablas.

- Ejemplo: 'tabla1, t able2, tabla3'.

- Ruta a su 'config.share' archivo.

Configuración de MS SQL Server

Deberá proporcionar los siguientes detalles de MS SQL Server:

- base de datos

- anfitrión

- contraseña

- esquema

- nombre de usuario

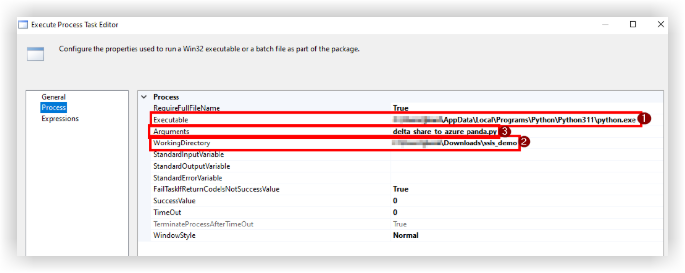

Configuración de SSIS

- Usando la línea de comandos, navegue a la carpeta ingresando'cd'.<path to the folder>

- Instale los paquetes necesarios usando 'pip install -r requirements.txt' o 'python -m pip install -r requirements.txt'.

- Abra SSIS y cree un nuevo proyecto.

- En el Cuadro de herramientas de SSIS, arrastre y suelte la actividad "Ejecutar tarea de proceso".

- Haga doble clic en 'Ejecutar tarea de proceso' y navegue hasta la pestaña Proceso.

- En 'Ejecutable', ingrese la ruta a python.exe en la carpeta de instalación de Python.

- En 'WorkingDirectory', ingrese una ruta a la carpeta que contiene el script que desea ejecutar (sin nombre de archivo de script).

- En 'Argumentos', ingrese el nombre del script 'delta_share_to_azure_panda.py' que desea ejecutar con el .py extensión y guardar.

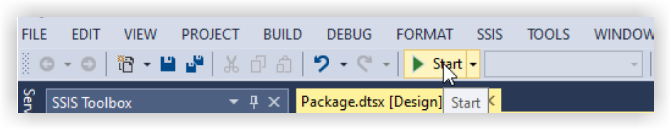

- Haga clic en el botón 'Inicio' en el panel superior:

- Durante la ejecución de la tarea, la salida de la consola de Python se muestra en la ventana de la consola externa.

- Una vez finalizada la tarea, mostrará una marca verde:

Conectarse a SQL Server mediante la biblioteca de Python

Descripción general

Esta guía proporciona instrucciones detalladas para configurar y usar el paquete de integración Delta Sharing en un sistema operativo Windows para integrar sin problemas los datos en sus flujos de trabajo con Procore Analytics. El paquete admite múltiples opciones de ejecución, lo que le permite elegir la configuración y el método de integración que desee.

Requisitos previos

Asegúrese de tener lo siguiente antes de continuar:

- SKU de Procore Analytics 2.0

- Archivo pofile de uso compartido de Delta:

Obtenga el archivo *.share que contiene las credenciales de uso compartido delta. Para mayor comodidad, cópielo en el directorio de paquetes. - Entorno Python: Instale Python 3 y pip en su sistema.

- Descarga Python.

- Como alternativa, use Microsoft Store.

Pasos

- Preparar el paquete

- Instalar dependencias

- Generar configuración

- Configurar cron jobs y ejecución inmediata

- Ejecución y Mantenimiento

Preparar el paquete

- Cree un nuevo archivo denominado config.share con sus credenciales de Delta Share en formato JSON.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"endpoint": "[2]"

}

- Obtener campos obligatorios.

Nota: Estos detalles se pueden obtener de la aplicación web Procore Analytics.- ShareCredentialsVersion: número de versión (actualmente 1).

- BearerToken: Su token de acceso a Delta Share.

- Punto de conexión: la URL del punto de conexión de Delta Share.

- Descargue y extraiga el paquete.

- Descomprima el paquete en un directorio de su elección.

- Copie el archivo de perfil *.share Delta Sharing en el directorio del paquete para facilitar el acceso.

Instalar dependencias

- Abra una terminal en el directorio de paquetes.

- Ejecute el siguiente comando para instalar las dependencias:

- pip install -r requirements.txt

Generar configuración

- Genere el archivo config.yaml ejecutando python user_exp.py:

Este script ayuda a generar el archivo config.yaml que contiene las credenciales y la configuración necesarias. - Al configurar la fuente de datos, se le pedirá que proporcione:

- Lista de tablas (separadas por comas).

- Dejar en blanco para sincronizar todas las tablas.

Ejemplo: 'tabla1, tabla2, tabla3'. - Ruta a su 'config.share' archivo.

- Por primera vez, proporcionará sus credenciales, como la ubicación de configuración de origen de Delta Share, las tablas, la base de datos, el host, etc.

Nota: Después, puede reutilizar o actualizar la configuración manualmente o mediante el user_exp.py python en ejecución nuevamente.

Configurar cron jobs y ejecución inmediata (opcional)

- Decida si desea configurar un cron job para su ejecución automática.

- Proporcione un cron schedule:

- Formato: * * * * * ( minuto, hora, día del mes, mes, día de la semana).

- Ejemplo de ejecución diaria a las 2 de la madrugada: 0 2 * * *

- Para verificar los registros de programación, el archivo 'procore_scheduling.log' se creará tan pronto como se configure la programación.

También puede verificar la programación ejecutando el comando en la terminal:

Para Linux y MacOs:

Para editar/eliminar - edite el cron de programación usando:

'''bash

EDITOR=nano crontab -e

```

- Después de ejecutar el comando anterior, debería ver algo similar a:

- 2 * * * * /Usuarios/your_user/copo de nieve/venv/bin/python /Usuarios/your_user/copo de nieve/sql_server_python/connection_config.py 2>&1 | mientras se lee la línea; do echo "$(fecha) - $line"; done >> /Usuarios/your_user/copo de nieve/sql_server_python/procore_scheduling.log # procore-data-import

- También puede ajustar el cron de programación o eliminar toda la línea para que deje de ejecutarse según el programa.

Para Windows:

- Compruebe que se ha creado la tarea de programa:

'''PowerShell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - Para editar/eliminar - tarea de programación:

Abra el Programador de tareas:- Presione Win + R, escriba taskschd.msc, y presione Enter.

- Navegue hasta las tareas programadas.

- En el panel izquierdo, expanda la Biblioteca del programador de tareas.

- Busque la carpeta donde está guardada su tarea (por ejemplo, Biblioteca del programador de tareas o una carpeta personalizada).

- Encuentre su tarea:

- Busque el nombre de la tarea: ProcoreDeltaShareScheduling.

- Haga clic en él para ver sus detalles en el panel inferior.

- Verifica su horario:

- Compruebe la pestaña Desencadenadores para ver cuándo está configurada la tarea para ejecutarse.

- Compruebe la pestaña Historial para confirmar las ejecuciones recientes.

- Para eliminar la tarea:

- Eliminar tarea de la GUI.

Pregunta de ejecución inmediata:

- Opción de ejecutar un script para copiar datos inmediatamente después de la configuración.

- Después de generar el archivo config.yaml, la CLI está lista para ejecutarse en cualquier momento de forma independiente, mediante la ejecución de un script para copiar datos, según el paquete. Vea los ejemplos a continuación:

Python delta_share_to_azure_panda.py

O

python delta_share_to_sql_spark.py

O

python delta_share_to_azure_dfs_spark.py

Ejecución y Mantenimiento

Problemas comunes y soluciones

- Configuración de Cron Job:

- Asegúrese de que los permisos del sistema estén configurados correctamente.

- Compruebe los registros del sistema si el trabajo no se puede ejecutar.

- Compruebe que el script delta_share_to_azure_panda.py tiene permisos de ejecución.

- Archivo de configuración:

- Asegúrese de que el archivo config.yaml esté en el mismo directorio que el script.

- Haga una copia de seguridad del archivo antes de realizar cambios.

Soporte

Para obtener ayuda adicional:

- Revise los registros de scripts para ver los mensajes de error detallados.

- Vuelva a comprobar si hay errores de configuración en el archivo config.yaml .

- Póngase en contacto con el administrador del sistema si tiene problemas relacionados con los permisos.

- Comuníquese con el soporte de Procore para problemas relacionados con el acceso a Delta Share.

- Registro de revisión de tablas con errores: failed_tables.log.

Notas

- Siempre haga una copia de seguridad de sus archivos de configuración antes de realizar cambios.

- Pruebe nuevas configuraciones en un entorno que no sea de producción para evitar interrupciones.

Conexión a SQL Server mediante Python Spark

Descripción general

Esta guía proporciona instrucciones detalladas para configurar y usar el paquete de integración Delta Sharing en un sistema operativo Windows para integrar sin problemas los datos en sus flujos de trabajo con Procore Analytics. El paquete admite múltiples opciones de ejecución, lo que le permite elegir la configuración y el método de integración que desee.

Requisitos previos

Asegúrese de tener lo siguiente antes de continuar:

- SKU de Procore Analytics 2.0

- Archivo pofile de uso compartido de Delta:

Obtenga el archivo *.share que contiene las credenciales de uso compartido delta. Para mayor comodidad, cópielo en el directorio de paquetes. - Entorno Python: Instale Python 3 y pip en su sistema.

- Descarga Python.

- Como alternativa, use Microsoft Store.

Pasos

- Preparar el paquete

- Instalar dependencias

- Generar configuración

- Configurar cron jobs y ejecución inmediata

- Ejecución y Mantenimiento

Preparar el paquete

- Cree un nuevo archivo denominado config.share con sus credenciales de Delta Share en formato JSON.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"endpoint": "[3]"

}

- Obtener campos obligatorios.

Nota: Estos detalles se pueden obtener de la aplicación web Procore Analytics.- ShareCredentialsVersion: número de versión (actualmente 1).

- BearerToken: Su token de acceso a Delta Share.

- Punto de conexión: la URL del punto de conexión de Delta Share.

- Descargue y extraiga el paquete.

- Descomprima el paquete en un directorio de su elección.

- Copie el archivo de perfil *.share Delta Sharing en el directorio del paquete para facilitar el acceso.

Instalar dependencias

- Abra una terminal en el directorio de paquetes.

- Ejecute el siguiente comando para instalar las dependencias:

- pip install -r requirements.txt

Generar configuración

- Genere el archivo config.yaml ejecutando python user_exp.py:

Este script ayuda a generar el archivo config.yaml que contiene las credenciales y la configuración necesarias. - Al configurar la fuente de datos, se le pedirá que proporcione:

- Lista de tablas (separadas por comas).

- Dejar en blanco para sincronizar todas las tablas.

Ejemplo: 'tabla1, tabla2, tabla3'. - Ruta a su 'config.share' archivo.

- Por primera vez, proporcionará sus credenciales, como la ubicación de configuración de origen de Delta Share, las tablas, la base de datos, el host, etc.

Nota: Después, puede reutilizar o actualizar la configuración manualmente o mediante el user_exp.py python en ejecución nuevamente.

Configurar cron jobs y ejecución inmediata (opcional)

- Decida si desea configurar un cron job para su ejecución automática.

- Proporcione un cron schedule:

- Formato: * * * * * ( minuto, hora, día del mes, mes, día de la semana).

- Ejemplo de ejecución diaria a las 2 de la madrugada: 0 2 * * *

- Para verificar los registros de programación, el archivo 'procore_scheduling.log' se creará tan pronto como se configure la programación.

También puede verificar la programación ejecutando el comando en la terminal:

Para Linux y MacOs:

Para editar/eliminar - edite el cron de programación usando:

'''bash

EDITOR=nano crontab -e

```

- Después de ejecutar el comando anterior, debería ver algo similar a:

- 2 * * * * /Usuarios/your_user/copo de nieve/venv/bin/python /Usuarios/your_user/copo de nieve/sql_server_python/connection_config.py 2>&1 | mientras se lee la línea; do echo "$(fecha) - $line"; done >> /Usuarios/your_user/copo de nieve/sql_server_python/procore_scheduling.log # procore-data-import

- También puede ajustar el cron de programación o eliminar toda la línea para que deje de ejecutarse según el programa.

Para Windows:

- Compruebe que se ha creado la tarea de programa:

'''PowerShell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - Para editar/eliminar - tarea de programación:

Abra el Programador de tareas:- Presione Win + R, escriba taskschd.msc, y presione Enter.

- Navegue hasta las tareas programadas.

- En el panel izquierdo, expanda la Biblioteca del programador de tareas.

- Busque la carpeta donde está guardada su tarea (por ejemplo, Biblioteca del programador de tareas o una carpeta personalizada).

- Encuentre su tarea:

- Busque el nombre de la tarea: ProcoreDeltaShareScheduling.

- Haga clic en él para ver sus detalles en el panel inferior.

- Verifica su horario:

- Compruebe la pestaña Desencadenadores para ver cuándo está configurada la tarea para ejecutarse.

- Compruebe la pestaña Historial para confirmar las ejecuciones recientes.

- Para eliminar la tarea:

- Eliminar tarea de la GUI.

Pregunta de ejecución inmediata:

- Opción de ejecutar un script para copiar datos inmediatamente después de la configuración.

- Después de generar el archivo config.yaml, la CLI está lista para ejecutarse en cualquier momento de forma independiente, mediante la ejecución de un script para copiar datos, según el paquete. Vea los ejemplos a continuación:

Python delta_share_to_azure_panda.py

O

python delta_share_to_sql_spark.py

O

python delta_share_to_azure_dfs_spark.py

Ejecución y Mantenimiento

Problemas comunes y soluciones

- Configuración de Cron Job:

- Asegúrese de que los permisos del sistema estén configurados correctamente.

- Compruebe los registros del sistema si el trabajo no se puede ejecutar.

- Compruebe que el script delta_share_to_azure_panda.py tiene permisos de ejecución.

- Archivo de configuración:

- Asegúrese de que el archivo config.yaml esté en el mismo directorio que el script.

- Haga una copia de seguridad del archivo antes de realizar cambios.

Soporte

Para obtener ayuda adicional:

- Revise los registros de scripts para ver los mensajes de error detallados.

- Vuelva a comprobar si hay errores de configuración en el archivo config.yaml .

- Póngase en contacto con el administrador del sistema si tiene problemas relacionados con los permisos.

- Comuníquese con el soporte de Procore para problemas relacionados con el acceso a Delta Share.

- Registro de revisión de tablas con errores: failed_tables.log.

Notas

- Siempre haga una copia de seguridad de sus archivos de configuración antes de realizar cambios.

- Pruebe nuevas configuraciones en un entorno que no sea de producción para evitar interrupciones.

Conexión a ADLS mediante Azure Functions

Descripción general

Esta guía le guía a través de la configuración e implementación de una función de Azure para integrar datos de uso compartido delta con Procore Analytics. La función de Azure permite el procesamiento eficaz de datos y el uso compartido de flujos de trabajo con perfiles de uso compartido diferencial.

Requisitos previos

- SKU de Procore Analytics 2.0.

- Archivo de perfil de uso compartido delta:

- Su archivo *.share que contiene credenciales de uso compartido delta. Para mayor comodidad, colóquelo dentro del paquete descargado.

- Entorno de Python:

- Instaló Python 3.9+ y pip en su sistema.

- Configuración de Azure:

- CLI de Azure instalada e iniciada sesión.

- Herramientas esenciales de Azure Functions instaladas.

Pasos

- Prepare the Package

- Install Dependencies

- Generate Configuration

- Azure CLI Setup

- Install Azure Functions Core Tools

- Prepare the Azure Function

- Deployment

- Validation

Preparar el paquete

- Descargue el paquete requerido (adls_azure_function o sql_server_azure_function).

- Extraiga los archivos del paquete a un directorio local.

- Coloque el archivo de uso compartido de Delta:

- Copie su archivo de perfil *.share Delta Sharing en el directorio extraído.

Instalar dependencias

- Abra una terminal en el directorio de paquetes.

- Ejecute el siguiente comando para instalar las dependencias de Python necesarias:

- pip install -r requirements.txt

Generar configuración

- Genere el archivo config.yaml ejecutando:

- Python user_exp.py

- El script le pedirá que introduzca credenciales como:

- Mesas

- Nombre de la base de datos

- Anfitrión

- Credenciales adicionales..

- La configuración se puede reutilizar o actualizar manualmente o volviendo a ejecutar python user_exp.py.

Configuración de la CLI de Azure

- Inicie sesión en Azure.

- Ejecute el siguiente comando para iniciar sesión:

az login - Comprobación de la cuenta de Azure:

- az account show

- Si el comando az no está disponible, instale la CLI de Azure siguiendo las instrucciones que se encuentran aquí: Microsoft Learn.

Instalación de las herramientas esenciales de Azure Functions

Vete a

para obtener instrucciones sobre cómo instalar las herramientas esenciales de Azure Functions.Preparación de la función de Azure

- Utilizar elpara crear lo siguiente:

- Una aplicación de funciones

- Un grupo de recursos

- Plan de consumo

- Cuenta de almacenamiento

- Establecer un programa de cron personalizado (opcional).

- Abra function_app.py en un editor.

- Localice la línea: @app.timer_trigger(schedule="0 0 */8 * * *",

- Reemplace la programación con su expresión Cron personalizada y guarde el archivo.

Despliegue

- Abra un terminal en el directorio de paquetes (adls_azure_function).

- Ejecute el siguiente comando de implementación:

- func azure functionapp publish <FunctionAppName> --build remote --python --clean

- Reemplace <FunctionAppName> por el nombre de la aplicación de funciones de Azure en la suscripción de Azure.

Validación

- Asegúrese de que la implementación se realiza correctamente comprobando el estado de la aplicación de funciones en el Portal de Azure.

- Supervise los registros para comprobar que la función se está ejecutando según lo previsto.

Conéctese a ADLS mediante Python

Descripción general

Esta guía proporciona instrucciones detalladas para configurar y usar el paquete de integración Delta Sharing en un sistema operativo Windows para integrar sin problemas los datos en sus flujos de trabajo con Procore Analytics. El paquete admite múltiples opciones de ejecución, lo que le permite elegir la configuración y el método de integración que desee.

Requisitos previos

Asegúrese de tener lo siguiente antes de continuar:

- SKU de Procore Analytics 2.0

- Archivo pofile de uso compartido de Delta:

Obtenga el archivo *.share que contiene las credenciales de uso compartido delta. Para mayor comodidad, cópielo en el directorio de paquetes. - Entorno Python: Instale Python 3 y pip en su sistema.

- Descarga Python.

- Como alternativa, use Microsoft Store.

Pasos

- Preparar el paquete

- Instalar dependencias

- Generar configuración

- Configurar cron jobs y ejecución inmediata

- Ejecución y Mantenimiento

Preparar el paquete

- Cree un nuevo archivo denominado config.share con sus credenciales de Delta Share en formato JSON.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"endpoint": "[4]"

}

- Obtener campos obligatorios.

Nota: Estos detalles se pueden obtener de la aplicación web Procore Analytics.- ShareCredentialsVersion: número de versión (actualmente 1).

- BearerToken: Su token de acceso a Delta Share.

- Punto de conexión: la URL del punto de conexión de Delta Share.

- Descargue y extraiga el paquete.

- Descomprima el paquete en un directorio de su elección.

- Copie el archivo de perfil *.share Delta Sharing en el directorio del paquete para facilitar el acceso.

Instalar dependencias

- Abra una terminal en el directorio de paquetes.

- Ejecute el siguiente comando para instalar las dependencias:

- pip install -r requirements.txt

Generar configuración

- Genere el archivo config.yaml ejecutando python user_exp.py:

Este script ayuda a generar el archivo config.yaml que contiene las credenciales y la configuración necesarias. - Al configurar la fuente de datos, se le pedirá que proporcione:

- Lista de tablas (separadas por comas).

- Dejar en blanco para sincronizar todas las tablas.

Ejemplo: 'tabla1, tabla2, tabla3'. - Ruta a su 'config.share' archivo.

- Por primera vez, proporcionará sus credenciales, como la ubicación de configuración de origen de Delta Share, las tablas, la base de datos, el host, etc.

Nota: Después, puede reutilizar o actualizar la configuración manualmente o mediante el user_exp.py python en ejecución nuevamente.

Configurar cron jobs y ejecución inmediata (opcional)

- Decida si desea configurar un cron job para su ejecución automática.

- Proporcione un cron schedule:

- Formato: * * * * * ( minuto, hora, día del mes, mes, día de la semana).

- Ejemplo de ejecución diaria a las 2 de la madrugada: 0 2 * * *

- Para verificar los registros de programación, el archivo 'procore_scheduling.log' se creará tan pronto como se configure la programación.

También puede verificar la programación ejecutando el comando en la terminal:

Para Linux y MacOs:

Para editar/eliminar - edite el cron de programación usando:

'''bash

EDITOR=nano crontab -e

```

- Después de ejecutar el comando anterior, debería ver algo similar a:

- 2 * * * * /Usuarios/your_user/copo de nieve/venv/bin/python /Usuarios/your_user/copo de nieve/sql_server_python/connection_config.py 2>&1 | mientras se lee la línea; do echo "$(fecha) - $line"; done >> /Usuarios/your_user/copo de nieve/sql_server_python/procore_scheduling.log # procore-data-import

- También puede ajustar el cron de programación o eliminar toda la línea para que deje de ejecutarse según el programa.

Para Windows:

- Compruebe que se ha creado la tarea de programa:

'''PowerShell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - Para editar/eliminar - tarea de programación:

Abra el Programador de tareas:- Presione Win + R, escriba taskschd.msc, y presione Enter.

- Navegue hasta las tareas programadas.

- En el panel izquierdo, expanda la Biblioteca del programador de tareas.

- Busque la carpeta donde está guardada su tarea (por ejemplo, Biblioteca del programador de tareas o una carpeta personalizada).

- Encuentre su tarea:

- Busque el nombre de la tarea: ProcoreDeltaShareScheduling.

- Haga clic en él para ver sus detalles en el panel inferior.

- Verifica su horario:

- Compruebe la pestaña Desencadenadores para ver cuándo está configurada la tarea para ejecutarse.

- Compruebe la pestaña Historial para confirmar las ejecuciones recientes.

- Para eliminar la tarea:

- Eliminar tarea de la GUI.

Pregunta de ejecución inmediata:

- Opción de ejecutar un script para copiar datos inmediatamente después de la configuración.

- Después de generar el archivo config.yaml, la CLI está lista para ejecutarse en cualquier momento de forma independiente, mediante la ejecución de un script para copiar datos, según el paquete. Vea los ejemplos a continuación:

Python delta_share_to_azure_panda.py

O

python delta_share_to_sql_spark.py

O

python delta_share_to_azure_dfs_spark.py

Ejecución y Mantenimiento

Problemas comunes y soluciones

- Configuración de Cron Job:

- Asegúrese de que los permisos del sistema estén configurados correctamente.

- Compruebe los registros del sistema si el trabajo no se puede ejecutar.

- Compruebe que el script delta_share_to_azure_panda.py tiene permisos de ejecución.

- Archivo de configuración:

- Asegúrese de que el archivo config.yaml esté en el mismo directorio que el script.

- Haga una copia de seguridad del archivo antes de realizar cambios.

Soporte

Para obtener ayuda adicional:

- Revise los registros de scripts para ver los mensajes de error detallados.

- Vuelva a comprobar si hay errores de configuración en el archivo config.yaml .

- Póngase en contacto con el administrador del sistema si tiene problemas relacionados con los permisos.

- Comuníquese con el soporte de Procore para problemas relacionados con el acceso a Delta Share.

- Registro de revisión de tablas con errores: failed_tables.log.

Notas

- Siempre haga una copia de seguridad de sus archivos de configuración antes de realizar cambios.

- Pruebe nuevas configuraciones en un entorno que no sea de producción para evitar interrupciones.

Conexión a ADLS mediante Spark

Descripción general

Esta guía proporciona instrucciones detalladas para configurar y usar el paquete de integración Delta Sharing en un sistema operativo Windows para integrar sin problemas los datos en sus flujos de trabajo con Procore Analytics. El paquete admite múltiples opciones de ejecución, lo que le permite elegir la configuración y el método de integración que desee.

Requisitos previos

Asegúrese de tener lo siguiente antes de continuar:

- SKU de Procore Analytics 2.0

- Archivo pofile de uso compartido de Delta:

Obtenga el archivo *.share que contiene las credenciales de uso compartido delta. Para mayor comodidad, cópielo en el directorio de paquetes. - Entorno Python: Instale Python 3 y pip en su sistema.

- Descarga Python.

- Como alternativa, use Microsoft Store.

Pasos

- Preparar el paquete

- Instalar dependencias

- Generar configuración

- Configurar cron jobs y ejecución inmediata

- Ejecución y Mantenimiento

Preparar el paquete

- Cree un nuevo archivo denominado config.share con sus credenciales de Delta Share en formato JSON.

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"endpoint": "[5]"

}

- Obtener campos obligatorios.

Nota: Estos detalles se pueden obtener de la aplicación web Procore Analytics.- ShareCredentialsVersion: número de versión (actualmente 1).

- BearerToken: Su token de acceso a Delta Share.

- Punto de conexión: la URL del punto de conexión de Delta Share.

- Descargue y extraiga el paquete.

- Descomprima el paquete en un directorio de su elección.

- Copie el archivo de perfil *.share Delta Sharing en el directorio del paquete para facilitar el acceso.

Instalar dependencias

- Abra una terminal en el directorio de paquetes.

- Ejecute el siguiente comando para instalar las dependencias:

- pip install -r requirements.txt

Generar configuración

- Genere el archivo config.yaml ejecutando python user_exp.py:

Este script ayuda a generar el archivo config.yaml que contiene las credenciales y la configuración necesarias. - Al configurar la fuente de datos, se le pedirá que proporcione:

- Lista de tablas (separadas por comas).

- Dejar en blanco para sincronizar todas las tablas.

Ejemplo: 'tabla1, tabla2, tabla3'. - Ruta a su 'config.share' archivo.

- Por primera vez, proporcionará sus credenciales, como la ubicación de configuración de origen de Delta Share, las tablas, la base de datos, el host, etc.

Nota: Después, puede reutilizar o actualizar la configuración manualmente o mediante el user_exp.py python en ejecución nuevamente.

Configurar cron jobs y ejecución inmediata (opcional)

- Decida si desea configurar un cron job para su ejecución automática.

- Proporcione un cron schedule:

- Formato: * * * * * ( minuto, hora, día del mes, mes, día de la semana).

- Ejemplo de ejecución diaria a las 2 de la madrugada: 0 2 * * *

- Para verificar los registros de programación, el archivo 'procore_scheduling.log' se creará tan pronto como se configure la programación.

También puede verificar la programación ejecutando el comando en la terminal:

Para Linux y MacOs:

Para editar/eliminar - edite el cron de programación usando:

'''bash

EDITOR=nano crontab -e

```

- Después de ejecutar el comando anterior, debería ver algo similar a:

- 2 * * * * /Usuarios/your_user/copo de nieve/venv/bin/python /Usuarios/your_user/copo de nieve/sql_server_python/connection_config.py 2>&1 | mientras se lee la línea; do echo "$(fecha) - $line"; done >> /Usuarios/your_user/copo de nieve/sql_server_python/procore_scheduling.log # procore-data-import

- También puede ajustar el cron de programación o eliminar toda la línea para que deje de ejecutarse según el programa.

Para Windows:

- Compruebe que se ha creado la tarea de programa:

'''PowerShell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

``` - Para editar/eliminar - tarea de programación:

Abra el Programador de tareas:- Presione Win + R, escriba taskschd.msc, y presione Enter.

- Navegue hasta las tareas programadas.

- En el panel izquierdo, expanda la Biblioteca del programador de tareas.

- Busque la carpeta donde está guardada su tarea (por ejemplo, Biblioteca del programador de tareas o una carpeta personalizada).

- Encuentre su tarea:

- Busque el nombre de la tarea: ProcoreDeltaShareScheduling.

- Haga clic en él para ver sus detalles en el panel inferior.

- Verifica su horario:

- Compruebe la pestaña Desencadenadores para ver cuándo está configurada la tarea para ejecutarse.

- Compruebe la pestaña Historial para confirmar las ejecuciones recientes.

- Para eliminar la tarea:

- Eliminar tarea de la GUI.

Pregunta de ejecución inmediata:

- Opción de ejecutar un script para copiar datos inmediatamente después de la configuración.

- Después de generar el archivo config.yaml, la CLI está lista para ejecutarse en cualquier momento de forma independiente, mediante la ejecución de un script para copiar datos, según el paquete. Vea los ejemplos a continuación:

Python delta_share_to_azure_panda.py

O

python delta_share_to_sql_spark.py

O

python delta_share_to_azure_dfs_spark.py

Ejecución y Mantenimiento

Problemas comunes y soluciones

- Configuración de Cron Job:

- Asegúrese de que los permisos del sistema estén configurados correctamente.

- Compruebe los registros del sistema si el trabajo no se puede ejecutar.

- Compruebe que el script delta_share_to_azure_panda.py tiene permisos de ejecución.

- Archivo de configuración:

- Asegúrese de que el archivo config.yaml esté en el mismo directorio que el script.

- Haga una copia de seguridad del archivo antes de realizar cambios.

Soporte

Para obtener ayuda adicional:

- Revise los registros de scripts para ver los mensajes de error detallados.

- Vuelva a comprobar si hay errores de configuración en el archivo config.yaml .

- Póngase en contacto con el administrador del sistema si tiene problemas relacionados con los permisos.

- Comuníquese con el soporte de Procore para problemas relacionados con el acceso a Delta Share.

- Registro de revisión de tablas con errores: failed_tables.log.

Notas

- Siempre haga una copia de seguridad de sus archivos de configuración antes de realizar cambios.

- Pruebe nuevas configuraciones en un entorno que no sea de producción para evitar interrupciones.

Conexión a Fabric Lakehouse mediante Data Factory

Descripción general

La integración de Delta Sharing con Microsoft Fabric Data Factory permite el acceso y el procesamiento sin problemas de tablas Delta compartidas para sus flujos de trabajo de análisis con Procore Analytics 2.0. Delta Sharing, un protocolo abierto para la colaboración segura de datos, garantiza que las organizaciones puedan compartir datos sin duplicación.

Requisitos previos

- SKU de Procore Analytics 2.0

- Credenciales de uso compartido de Delta:

- Obtenga el archivo de credenciales de usocompartido delta share.json (o equivalente) de su proveedor de datos.

- Este archivo debe incluir:

- URL del punto de conexión: la URL del servidor de uso compartido diferencial.

- Ficha al portador: Se utiliza para el acceso seguro a los datos.

- Configuración de Microsoft Fabric:

- Una cuenta de inquilino de Microsoft Fabric con una suscripción activa.

- Acceso a un área de trabajo habilitada para Microsoft Fabric.

Pasos

- Cambiar a la experiencia de Data Factory

- Configurar el flujo de datos

- Realizar transformaciones de datos

- Validación y Monitoreo

Cambiar a la experiencia de Data Factory

- Vaya al área de trabajo de Microsoft Fabric.

- Selecciona Nuevo y, luego, elige Dataflow Gen2.

Configurar el flujo de datos

- Vaya al editor de flujo de datos.

- Haga clic en Obtener datos y seleccione Más.

- En Nuevo origen, seleccione Otro uso compartido delta como origen de datos.

- Ingrese los siguientes detalles:

- URL: Desde el archivo de configuración de uso compartido diferencial.

- Token de portador: se encuentra en el archivo config.share.

- Haga clic en Siguiente y seleccione las tablas deseadas.

- Haga clic en Crear para completar la configuración.

Realizar transformaciones de datos

Después de configurar el flujo de datos, ahora puede aplicar transformaciones a los datos Delta compartidos. Elija su opción Delta Sharing Data de la siguiente lista:

- Agregar destino de datos

- Crear/Abrir Lakehouse

Agregar destino de datos

- Vaya a Data Factory.

- Haga clic en Agregar destino de datos.

- Seleccione Lakehouse como destino y haga clic en Siguiente.

- Elija su destino objetivo y confirme haciendo clic en Siguiente.

Crear-Abrir Casa del Lago

- Crea/abre tuLakehouse y haz clic en Obtener datos.

- Selecciona Nueva generación de Dataflow 2.

- Haga clic en Obtener datos, luego en Más y busque Uso compartido de Delta.

- Ingrese el token de portador de la URL de su archivo config.share y luego seleccione Next.

- Elija los datos o tablas que desee descargar y haga clic en Siguiente.

- Después de estas manipulaciones, debería tener todos los datos seleccionados en su Fabric Lakehouse.

Validación y Monitoreo

Pruebe sus canalizaciones y flujos de datos para garantizar una ejecución sin problemas. Uso de herramientas de supervisión en Datos

Fábrica para realizar un seguimiento del progreso y registros de cada actividad.

Conéctese a Fabric Lakehouse mediante cuadernos de tela

Descripción general

El uso de Data Factory en Microsoft Fabric con uso compartido de Delta permite una integración y un procesamiento perfectos de tablas Delta compartidas como parte de sus flujos de trabajo de análisis con Procore Analytics 2.0. Delta Sharing es un protocolo abierto para el intercambio seguro de datos, que permite la colaboración entre organizaciones sin duplicar datos.

Esta guía le guiará a través de los pasos para configurar y usar Data Factory en Fabric con Delta Sharing, utilizando Notebooks para procesar y exportar datos a un Lakehouse.

Requisitos previos

- SKU de Procore Analytics 2.0

- Credenciales de uso compartido de Delta:

- Acceso a las credenciales de uso compartido de Delta proporcionadas por un proveedor de datos.

- Un archivo de perfil de uso compartido (config.share) Contiene:

- URL del punto de conexión (URL del servidor de uso compartido delta).

- Token de acceso (token de portador para el acceso seguro a los datos).

- Cree el archivo config.yaml con credenciales específicas.

- Entorno de Microsoft Fabric:

- Una cuenta de inquilino de Microsoft Fabric con una suscripción activa.

- Un espacio de trabajo habilitado para Fabric.

- Paquetes y scripts:

- Descargue el paquete fabric-lakehouse. El directorio debe incluir:

- ds_to_lakehouse.py: Código del cuaderno.

- readme.md: Instrucciones.

- Descargue el paquete fabric-lakehouse. El directorio debe incluir:

Pasos

Configurar la configuración

- Cree el archivo config.yaml y defina la configuración en la siguiente estructura

source_config:

config_path: ruta/a/su/delta-compartir-credenciales-archivo.share

tablas: # Opcional - Dejar vacío para procesar todas las tablas

- table_name1

- table_name2

target_config:

lakehouse_path: ruta/a/tu/tela/lakehouse/Tablas/ # Ruta a la casa del lago de tela

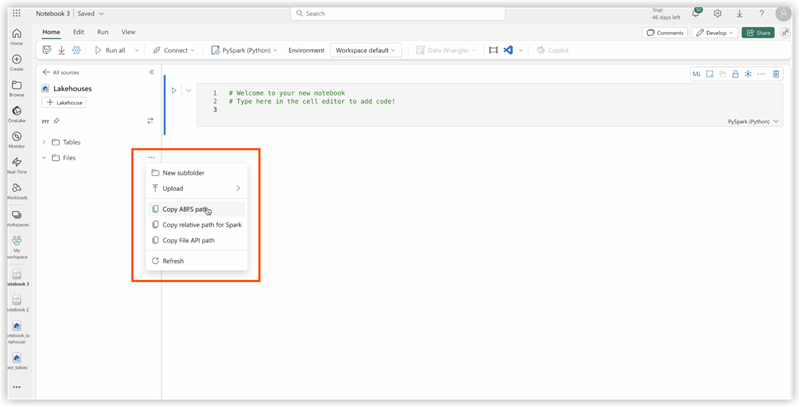

Configura tu Lakehouse

- Abra el área de trabajo de Microsoft Fabric.

- Navegue hasta su Lakehouse y haga clic en Abrir bloc de notas y, a continuación, en Nuevo bloc de notas.

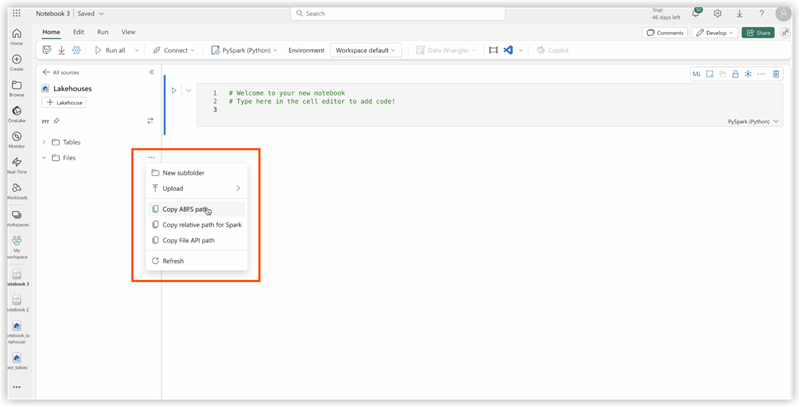

- Si no conoce el valor de config.yaml#lakehouse_path, Puedes copiarlo desde la pantalla.

- Haga clic en los puntos suspensivos en los archivos y seleccione Copiar ruta ABFS:

3. Copie el código de ds_to_lakehouse.py y péguelo en la ventana del cuaderno (Pyspark Python):

El siguiente paso es cargar sus propios config.yaml y config.share en la carpeta Resources de Lakehouse. Puede crear su propio directorio o usar un directorio integrado (ya creado para recursos por Lakehouse):

El siguiente ejemplo muestra un directorio interno estándar para un fichero config.yaml.

Nota: Asegúrese de cargar ambos archivos en el mismo nivel y para la propiedad config_path:

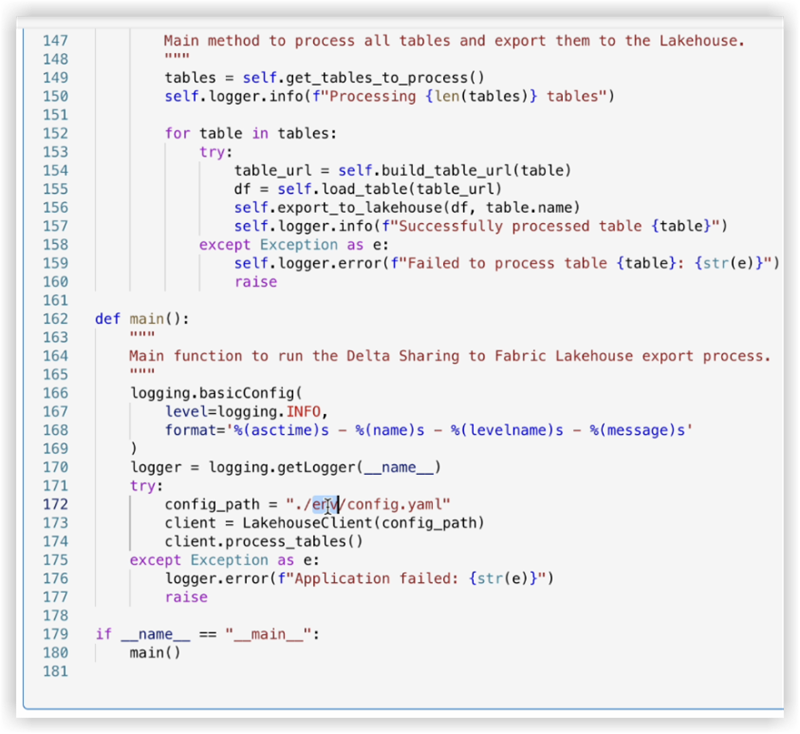

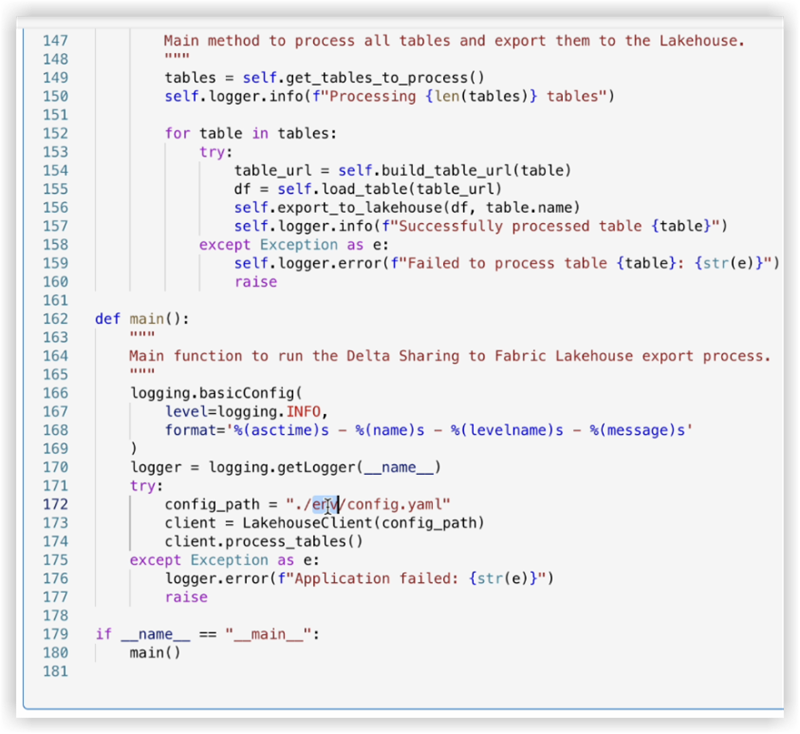

4. Verifique el código del cuaderno, líneas 170-175.

El siguiente ejemplo muestra los cambios de línea necesarios:

config_path = "./env/config.yaml"

Para

config_path = "./builtin/config.yaml"

Dado que los archivos están en una carpeta interna y no en un entorno personalizado, asegúrese de supervisar su propia estructura de archivos. Puede cargarlos en diferentes carpetas, pero en tales casos, actualice el código del bloc de notas para encontrar el archivo config.yaml correctamente.

5. Haga clic en Ejecutar celda:

Validación

- Una vez que se complete el trabajo, verifique que los datos se hayan copiado correctamente en su Lakehouse.

- Compruebe las tablas especificadas y asegúrese de que los datos coincidan con las tablas Delta compartidas.

- Espere hasta que finalice el trabajo, debe copiar todos los datos.

Conexión a SQL Server mediante Azure Functions

Descripción general

Esta guía le guía a través de la configuración e implementación de una función de Azure para integrar datos de uso compartido delta con Procore Analytics. La función de Azure permite el procesamiento eficaz de datos y el uso compartido de flujos de trabajo con perfiles de uso compartido diferencial.

Requisitos previos

- SKU de Procore Analytics 2.0.

- Archivo de perfil de uso compartido delta:

- Su archivo *.share que contiene credenciales de uso compartido delta. Para mayor comodidad, colóquelo dentro del paquete descargado.

- Entorno de Python:

- Instaló Python 3.9+ y pip en su sistema.

- Configuración de Azure:

- CLI de Azure instalada e iniciada sesión.

- Herramientas esenciales de Azure Functions instaladas.

Pasos

- Prepare the Package

- Install Dependencies

- Generate Configuration

- Azure CLI Setup

- Install Azure Functions Core Tools

- Prepare the Azure Function

- Deployment

- Validation

Preparar el paquete

- Descargue el paquete requerido (adls_azure_function o sql_server_azure_function).

- Extraiga los archivos del paquete a un directorio local.

- Coloque el archivo de uso compartido de Delta:

- Copie su archivo de perfil *.share Delta Sharing en el directorio extraído.

Instalar dependencias

- Abra una terminal en el directorio de paquetes.

- Ejecute el siguiente comando para instalar las dependencias de Python necesarias:

- pip install -r requirements.txt

Generar configuración

- Genere el archivo config.yaml ejecutando:

- Python user_exp.py

- El script le pedirá que introduzca credenciales como:

- Mesas

- Nombre de la base de datos

- Anfitrión

- Credenciales adicionales..

- La configuración se puede reutilizar o actualizar manualmente o volviendo a ejecutar python user_exp.py.

Configuración de la CLI de Azure

- Inicie sesión en Azure.

- Ejecute el siguiente comando para iniciar sesión:

az login - Comprobación de la cuenta de Azure:

- az account show

- Si el comando az no está disponible, instale la CLI de Azure siguiendo las instrucciones que se encuentran aquí: Microsoft Learn.

Instalación de las herramientas esenciales de Azure Functions

Vete a

para obtener instrucciones sobre cómo instalar las herramientas esenciales de Azure Functions.Preparación de la función de Azure

- Utilizar elpara crear lo siguiente:

- Una aplicación de funciones

- Un grupo de recursos

- Plan de consumo

- Cuenta de almacenamiento

- Establecer un programa de cron personalizado (opcional).

- Abra function_app.py en un editor.

- Localice la línea: @app.timer_trigger(schedule="0 0 */8 * * *",

- Reemplace la programación con su expresión Cron personalizada y guarde el archivo.

Despliegue

- Abra un terminal en el directorio de paquetes (adls_azure_function).

- Ejecute el siguiente comando de implementación:

- func azure functionapp publish <FunctionAppName> --build remote --python --clean

- Reemplace <FunctionAppName> por el nombre de la aplicación de funciones de Azure en la suscripción de Azure.

Validación

- Asegúrese de que la implementación se realiza correctamente comprobando el estado de la aplicación de funciones en el Portal de Azure.

- Supervise los registros para comprobar que la función se está ejecutando según lo previsto.

Conexión a SQL Server mediante Data Factory

Vista general

En este documento se proporcionan instrucciones paso a paso para configurar una canalización de datos en Microsoft Fabric para transferir datos de Delta Share a un almacén de SQL. Esta configuración permite una integración de datos perfecta entre los orígenes de Delta Lake y los destinos de SQL.

Requisitos previos

- Cuenta activa de Microsoft Fabric con los permisos adecuados.

- Credenciales de Delta Share.

- Credenciales de almacén de SQL.

- Acceso a Data Flow Gen2 en Fabric.

Pasos

- Acceder a Data Flow Gen2

- Configurar origen de datos

- Configurar la conexión Delta Share

- Configurar el destino de los datos

- Finalizar e implementar

- Verificación

- Solución de problemas

Acceder a Data Flow Gen2

- Inicie sesión en su cuenta de Microsoft Fabric.

- Navegue hasta el espacio de trabajo.

- Seleccione "Data Flow Gen2" entre las opciones disponibles.

Configurar origen de datos

- Haga clic en "Datos de otra fuente" para comenzar la configuración.

- En la pantalla Obtener datos, haga lo siguiente:

- Busque la barra de búsqueda con la etiqueta 'Elegir fuente de datos'.

- Escriba "delta sharing" en el campo de búsqueda.

- Seleccione Uso compartido delta en los resultados.

Configurar la conexión Delta Share

- Ingrese sus credenciales de Delta Share cuando se le solicite.

- Asegúrese de que todos los campos obligatorios se completen con precisión.

- Valide la conexión si es posible.

- Haga clic en 'Siguiente' para continuar.

- Revise la lista de tablas disponibles:

- Se mostrarán todas las mesas a las que tiene acceso.

- Seleccione las tablas deseadas para la transferencia.

Configurar el destino de los datos

- Haga clic en 'Agregar destino de datos'.

- Seleccione "Almacén SQL" como destino.

- Introduzca las credenciales SQL:

- Detalles del servidor.

- Información de autenticación.

- Especificaciones de la base de datos.

- Compruebe la configuración de la conexión.

Finalizar e implementar

- Revise todas las configuraciones.

- Haga clic en "Publicar" para implementar el flujo de datos.

- Espere el mensaje de confirmación.

Verificación

- Acceda a su almacén de SQL.

- Verifique que los datos estén disponibles y estructurados correctamente.

- Ejecute consultas de prueba para garantizar la integridad de los datos.

Solución de problemas

Problemas comunes y soluciones:

- Errores de conexión: compruebe las credenciales y la conectividad de red.

- Tablas que faltan: compruebe los permisos de uso compartido delta.

- Problemas de rendimiento: revise la configuración de optimización y asignación de recursos.

Conexión a SQL Server mediante Fabric Notebook

Descripción general

El uso de Data Factory en Microsoft Fabric con uso compartido de Delta permite una integración y un procesamiento perfectos de tablas Delta compartidas como parte de sus flujos de trabajo de análisis con Procore Analytics 2.0. Delta Sharing es un protocolo abierto para el intercambio seguro de datos, que permite la colaboración entre organizaciones sin duplicar datos.

Esta guía le guiará a través de los pasos para configurar y usar Data Factory en Fabric con Delta Sharing, utilizando Notebooks para procesar y exportar datos a un Lakehouse.

Requisitos previos

- SKU de Procore Analytics 2.0

- Credenciales de uso compartido de Delta:

- Acceso a las credenciales de uso compartido de Delta proporcionadas por un proveedor de datos.

- Un archivo de perfil de uso compartido (config.share) Contiene:

- URL del punto de conexión (URL del servidor de uso compartido delta).

- Token de acceso (token de portador para el acceso seguro a los datos).

- Cree el archivo config.yaml con credenciales específicas.

- Entorno de Microsoft Fabric:

- Una cuenta de inquilino de Microsoft Fabric con una suscripción activa.

- Un espacio de trabajo habilitado para Fabric.

- Paquetes y scripts:

- Descargue el paquete fabric-lakehouse. El directorio debe incluir:

- ds_to_lakehouse.py: Código del cuaderno.

- readme.md: Instrucciones.

- Descargue el paquete fabric-lakehouse. El directorio debe incluir:

Pasos

Configurar la configuración

- Cree el archivo config.yaml y defina la configuración en la siguiente estructura

source_config:

config_path: ruta/a/su/delta-compartir-credenciales-archivo.share

tablas: # Opcional - Dejar vacío para procesar todas las tablas

- table_name1

- table_name2

target_config:

lakehouse_path: ruta/a/tu/tela/lakehouse/Tablas/ # Ruta a la casa del lago de tela

Configura tu Lakehouse

- Abra el área de trabajo de Microsoft Fabric.

- Navegue hasta su Lakehouse y haga clic en Abrir bloc de notas y, a continuación, en Nuevo bloc de notas.

- Si no conoce el valor de config.yaml#lakehouse_path, Puedes copiarlo desde la pantalla.

- Haga clic en los puntos suspensivos en los archivos y seleccione Copiar ruta ABFS:

3. Copie el código de ds_to_lakehouse.py y péguelo en la ventana del cuaderno (Pyspark Python):

El siguiente paso es cargar sus propios config.yaml y config.share en la carpeta Resources de Lakehouse. Puede crear su propio directorio o usar un directorio integrado (ya creado para recursos por Lakehouse):

El siguiente ejemplo muestra un directorio interno estándar para un fichero config.yaml.

Nota: Asegúrese de cargar ambos archivos en el mismo nivel y para la propiedad config_path:

4. Verifique el código del cuaderno, líneas 170-175.

El siguiente ejemplo muestra los cambios de línea necesarios:

config_path = "./env/config.yaml"

Para

config_path = "./builtin/config.yaml"

Dado que los archivos están en una carpeta interna y no en un entorno personalizado, asegúrese de supervisar su propia estructura de archivos. Puede cargarlos en diferentes carpetas, pero en tales casos, actualice el código del bloc de notas para encontrar el archivo config.yaml correctamente.

5. Haga clic en Ejecutar celda:

Validación

- Una vez que se complete el trabajo, verifique que los datos se hayan copiado correctamente en su Lakehouse.

- Compruebe las tablas especificadas y asegúrese de que los datos coincidan con las tablas Delta compartidas.

- Espere hasta que finalice el trabajo, debe copiar todos los datos.

Conectar a Databricks

Nota:

Este método de conexión suele ser utilizado por profesionales de datos.- Inicie sesión en su entorno databricks.

- Navegue hasta la sección Catálogo .

- Seleccione Delta Sharing en el menú superior.

- Selecciona Compartido conmigo.

- Copie el Identificador de uso compartido que se le proporcionó.

- Comparta el Identificador de uso compartido con el equipo de soporte de Procore.

Nota: Una vez que se agrega el identificador de uso compartido al sistema de Procore, la conexión de Procore Databricks aparecerá en la pestaña Compartido conmigo en Proveedores en su entorno de Databricks. Los datos pueden tardar hasta 24 horas.

- Cuando la conexión de Procore Databricks sea visible en la pestaña Compartido conmigo, seleccione el identificador de Procore y haga clic en Crear catálogo.

- Introduzca el nombre que prefiera para el catálogo compartido y haga clic en Crear.

- El catálogo y las tablas compartidos ahora se mostrarán con el nombre proporcionado en el archivo Explorador de catálogos.

Comuníquese con el Soporte de Procore si tiene alguna pregunta o necesita ayuda.

Conéctese a Snowflake usando Python

Descripción general

La herramienta Procore Analytics Nube Connect Access es una interfaz de línea de comandos (CLI) que lo ayuda a configurar y administrar las transferencias de datos de Procore a Snowflake.

Consta de dos componentes principales:

- user_exp.py: Utilidad de configuración

- ds_to_snowflake.py: Script de sincronización de datos

Requisitos previos

- Python está instalado en su sistema

- Acceso a Procore Delta Share

- Credenciales de la cuenta de Snowflake

- Instale las dependencias necesarias mediante:

- pip install -r requirements.txt

Pasos

- Configuración inicial

- Sincronización de datos

- Configuración de origen de recurso compartido delta

- Configuración de destino de copo de nieve

- Opciones de programación

- Mejores prácticas

- Solución de problemas

Configuración inicial

Ejecute la utilidad de configuración usando python user_exp.py.

Sincronización de datos

Después de la configuración, tiene dos opciones para ejecutar la sincronización de datos:

- Ejecución directa:

- Python ds_to_snowflake.py

- Ejecución programada

- Si se configura durante la configuración, el trabajo se ejecutará automáticamente de acuerdo con su programa Cron.

- Para verificar los registros de programación, el archivo 'procore_scheduling.log' se creará tan pronto como se configure la programación.

- Además, puede verificar la programación ejecutando el comando en la terminal:

Para Linux y MacOS:

- Para editar/eliminar - edite el cron de programación usando:

'''bash

EDITOR=nano crontab -e

``` - Después de ejecutar el comando anterior, debería ver algo similar a:

2 * * * *

/usuarios/your_user/copo de nieve/venv/bin/python

/usuarios/your_user/copo de nieve/sql_server_python/connection_config.py

2> y 1 | mientras se lee la línea; do echo "$(fecha) - $line"; ¡Listo>>

/usuarios/your_user/copo de nieve/sql_server_python/procore_scheduling.log # procore-data-import - También puede ajustar el cron de programación o eliminar toda la línea para que deje de ejecutarse según el programa.

Para Windows:

- Compruebe que se ha creado la tarea de programa:

```

PowerShell

schtasks /query /tn "ProcoreDeltaShareScheduling" /fo LIST /v

```

- Para editar/eliminar la tarea de programación, abra el Programador de tareas.

- Presione Win + R, escriba taskschd.msc, y presione ENTER.

- Navegue hasta las tareas programadas.

- En el panel izquierdo, expanda la Biblioteca del programador de tareas.

- Busque la carpeta donde está guardada su tarea:

Ejemplo: Biblioteca del programador de tareas o una carpeta personalizada. - Encuentre su tarea.

- Busque el nombre de la tarea: ProcoreDeltaShareScheduling.

- Haga clic en él para ver los detalles en el panel inferior.

- Verifica su horario:

- Compruebe la pestaña Desencadenadores para ver cuándo está configurada la tarea para ejecutarse.

- Compruebe la pestaña Historial para confirmar las ejecuciones recientes.

- Para eliminar la tarea:

- Eliminar tarea de la GUI.

Configuración de recursos compartidos delta

- Creación del archivo config.share

- Antes de ejecutar la utilidad de configuración, debe crear un archivo config.share con sus credenciales de Delta Share. El archivo debe estar en formato JSON:

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"endpoint": "[6]"

}

- Campos obligatorios:

- ShareCredentialsVersion: número de versión (actualmente 1).

- BearerToken: Su token de acceso a Delta Share.

- Punto de conexión: la URL del punto de conexión de Delta Share.

- Estos detalles se pueden obtener en la interfaz de usuario web de Procore.

- Pasos para crear config.share:

- Cree un nuevo archivo llamado config.share.

- Copie la plantilla JSON anterior.

- Reemplace los valores de marcador de posición por sus credenciales reales.

- Guarde el archivo en un lugar seguro.

- Deberá proporcionar la ruta de acceso a este archivo durante la configuración. Al configurar la fuente de datos, se le pedirá que proporcione:

- Lista de tablas (separadas por comas).

- Dejar en blanco para sincronizar todas las tablas.

- Ejemplo: tabla1, tabla2, tabla3.

- Ruta de acceso al archivo config.share .

Configuración de copo de nieve

Deberá proporcionar los siguientes detalles de Snowflake:

- Autenticación (elija una):

- Autenticación de usuario

- Nombre de usuario

- Contraseña (ingresada de forma segura)

- Autenticación de usuario

- Autenticación de par de claves

- Nombre de usuario

- Ruta del archivo de clave privada

- Contraseña del archivo de clave privada

- Detalles de la conexión:

- Identificador de cuenta

- Nombre del almacén

- Nombre de la base de datos

- Nombre del esquema

- Número de subprocesos simultáneos

Opciones de programación

La herramienta ofrece la posibilidad de programar la sincronización automática de datos.

- Configuración de Cron Job

- Elegir si desea configurar un trabajo diario

- En caso afirmativo, proporcione un cron schedule

- Formato: * * * * * (minuto, hora, día del mes, mes, día de la semana)

- Ejemplo para todos los días a las 2 a.m.: 0 2 * * *

- Ejecución inmediata

- Opción para ejecutar el ds_to_snowflake.py inmediatamente después de la configuración

- Estructura de archivos

Unset

├── requirements.txt # Dependencias

├── user_exp.py # Utilidad de configuración

├── ds_to_snowflake.py # Script de sincronización de datos

├── config.yaml # Configuración generada

├── config.share # Archivo de configuración de Delta Share

├── procore_scheduling.log # Registro de ejecuciones de programación

Ejemplo de uso- Paso 1: Instalar dependencias

$ pip install -r requirements.txt - Paso 2: Ejecutar la utilidad de configuración

$ python user_exp.py - Acceso a Procore Analytics Nube Connect

- Esta CLI lo ayudará a elegir su almacén de origen y destino para acceder/escribir datos de Procore en Snowflake.

- Presione Enter para continuar.

- Ingrese a la lista de tablas (separadas por comas), déjela en blanco para todas las tablas: proyectos, usuarios, tareas.

- Ingrese la ruta a config.share: /ruta/a/config.share.

- Ingrese el nombre de usuario: snowflake_user.

- ¿Qué tipo de autenticación desea utilizar? (usuario/key_pair): Ingresar.

- 1 para el usuario,

- 2 para el par de claves:

- 1

- Ingrese la contraseña: ********

- Ingrese la cuenta: my_account

- Entrar en el almacén: my_warehouse

- Ingrese el nombre de la base de datos: procore_db

- Introduzca el nombre del esquema: procore_schema

- Introduzca el número de hilos: 4

- ¿Quieres configurar esto como un trabajo diario en cron? (Sí/No): Sí

- Ingrese el programa en formato cron (por ejemplo, * * * * * ): 0 2 * * *

- ¿Desea ejecutar el trabajo ahora? (Sí/No): Sí

- Paso 3: Ejecución manual (si es necesario)

$ python ds_to_snowflake.py

- Paso 1: Instalar dependencias

- Reutilización de la configuración

La herramienta guarda su configuración en el archivo config.yaml y le ofrece reutilizar la configuración almacenada anteriormente:- La configuración de origen se puede reutilizar.

- La configuración de destino (copo de nieve) se puede reutilizar.

- Puede optar por actualizar cualquiera de las configuraciones de forma independiente.

Prácticas recomendadas

- Autenticación

- Utilice la autenticación de par de claves siempre que sea posible.

- Rotar las credenciales con regularidad.

- Utilice los permisos mínimos requeridos.

- Rendimiento

- Ajuste el número de subprocesos en función de las capacidades de su sistema.

- Comience con un subconjunto más pequeño de tablas para realizar pruebas.

Solución de problemas

- Problemas comunes y soluciones:

- Tipo de autenticación no válido

- Asegúrese de seleccionar "1" (usuario) o "2" (key_pair) cuando se le solicite.

- Tipo de autenticación no válido

- Configuración de Cron Job

- Verifique que tiene los permisos del sistema adecuados.

- Compruebe los registros del sistema si el trabajo no se puede ejecutar.

- Asegúrese de que el ds_to_snowflake.py tenga los permisos correctos.

- Verifique la configuración del trabajo cron comprobando los registros del sistema:

Consulte el archivo 'procore_scheduling.log '.

- Archivo de configuración

- Ubicado en el mismo directorio que el script,

- Llamado config.yaml.

- Haga una copia de seguridad antes de realizar cualquier cambio.

- Soporte

- Compruebe la salida de registro del script.

- Revise su archivo config.yaml .

- Póngase en contacto con el administrador del sistema si tiene problemas relacionados con los permisos.

- Comuníquese con el soporte de Procore para problemas de acceso a Delta Share.

Nota: Recuerde siempre hacer una copia de seguridad de su configuración antes de realizar cambios y probar primero las nuevas configuraciones en un entorno que no sea de producción.

Conéctese a Amazon S3 mediante Python

Descripción general

La herramienta Procore Analytics Nube Connect Access es una interfaz de línea de comandos (CLI) que le ayuda a configurar y administrar las transferencias de datos de Procore a Amazon S3 con Procore Analytics 2.0.

Consta de dos componentes principales:

- user_exp.py: Utilidad de configuración

- delta_share_to_s3.py: Script de sincronización de datos

Requisitos previos

- SKU de Procore Analytics 2.0

- Python está instalado en su sistema

- Acceso a Procore Delta Share

- Claves de acceso de S3

- Instalación de las dependencias requeridas mediante:

- pip install -r requirements.txt

Pasos

- Configuración inicial

- Configuración de origen de recurso compartido delta

- Configuración de S3

- Opciones de programación

- Mejores prácticas

- Solución de problemas

Configuración inicial

Ejecute la utilidad de configuración usando python user_exp.py.

Esto te ayudará a configurar lo siguiente:

- Configuración de recursos compartidos delta

- Configuración de destino de S3

- Preferencias de programación

Configuración de recursos compartidos delta

- Creación del archivo config.share

- Antes de ejecutar la utilidad de configuración, debe crear un archivo config.share con sus credenciales de Delta Share. El archivo debe estar en formato JSON:

{

"shareCredentialsVersion": 1,

"bearerToken": "xxxxxxxxxxxxx",

"punto final": "xxxxxx"

}

- Campos obligatorios:

- ShareCredentialsVersion: número de versión (actualmente 1).

- BearerToken: Su token de acceso a Delta Share.

- Punto de conexión: la URL del punto de conexión de Delta Share.

- Estos detalles se pueden obtener en la interfaz de usuario web de Procore.

- Pasos para crear config.share:

- Cree un nuevo archivo llamado config.share.

- Copie la plantilla JSON anterior.

- Reemplace los valores de marcador de posición por sus credenciales reales.

- Guarde el archivo en un lugar seguro.

- Deberá proporcionar la ruta de acceso a este archivo durante la configuración. Al configurar la fuente de datos, se le pedirá que proporcione:

- Lista de tablas (separadas por comas).

- Dejar en blanco para sincronizar todas las tablas.

- Ejemplo: tabla1, tabla2, tabla3.

- Ruta de acceso al archivo config.share .

Configuración de S3

Deberá proporcionar los siguientes detalles de S3:

- Autenticación:

- Tecla de acceso

- Clave secreta

- Nombre del bucket sin s3://

- Clave - Directorio

Opciones de programación

La herramienta ofrece la posibilidad de programar la sincronización automática de datos.

- Configuración de Cron Job

- Elija si desea configurar un trabajo diario.

- En caso afirmativo, proporcione un cron schedule.

- Formato: * * * * * (minuto, hora, día del mes, mes, día de la semana).

- Ejemplo para todos los días a las 2 a.m.: 0 2 * * *